Wszystkie znaki na Ziemi i niebie wskazują, że rok 2017 przyniesie w technologiach pomiarowych kilka przełomów oraz wiele interesujących zmian i innowacji. Prezentujemy subiektywne zestawienie najciekawszych z nich.

1. Chmura ze słoika

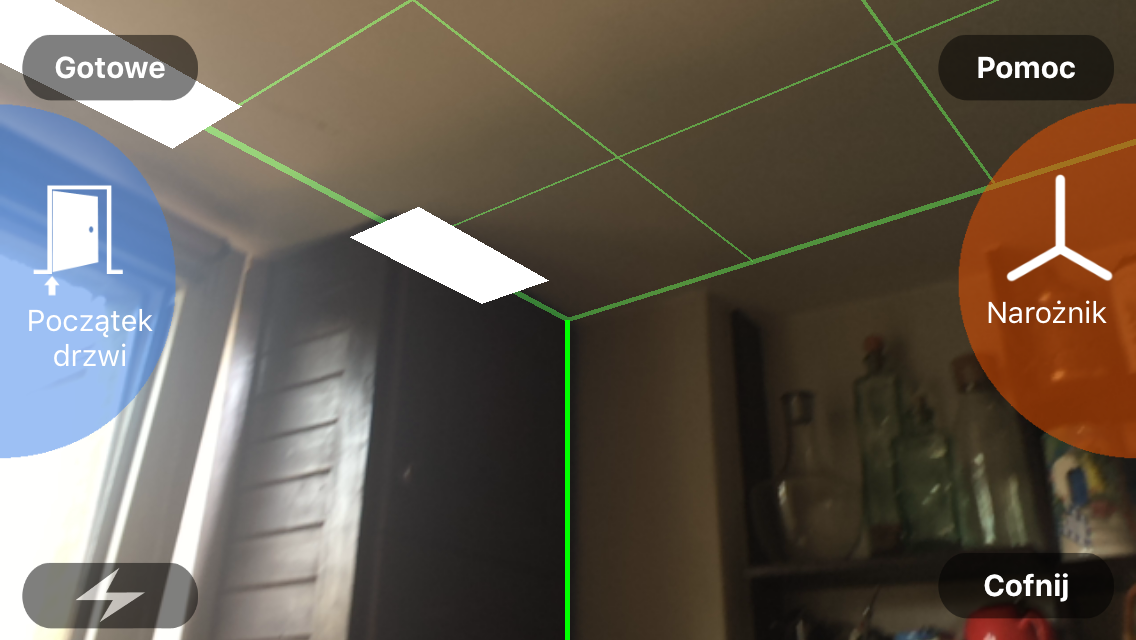

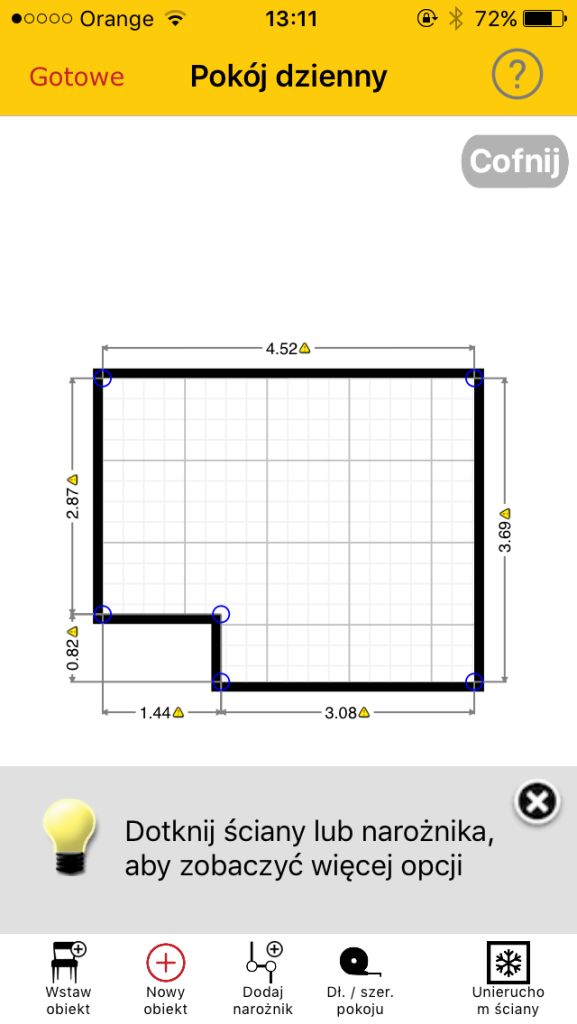

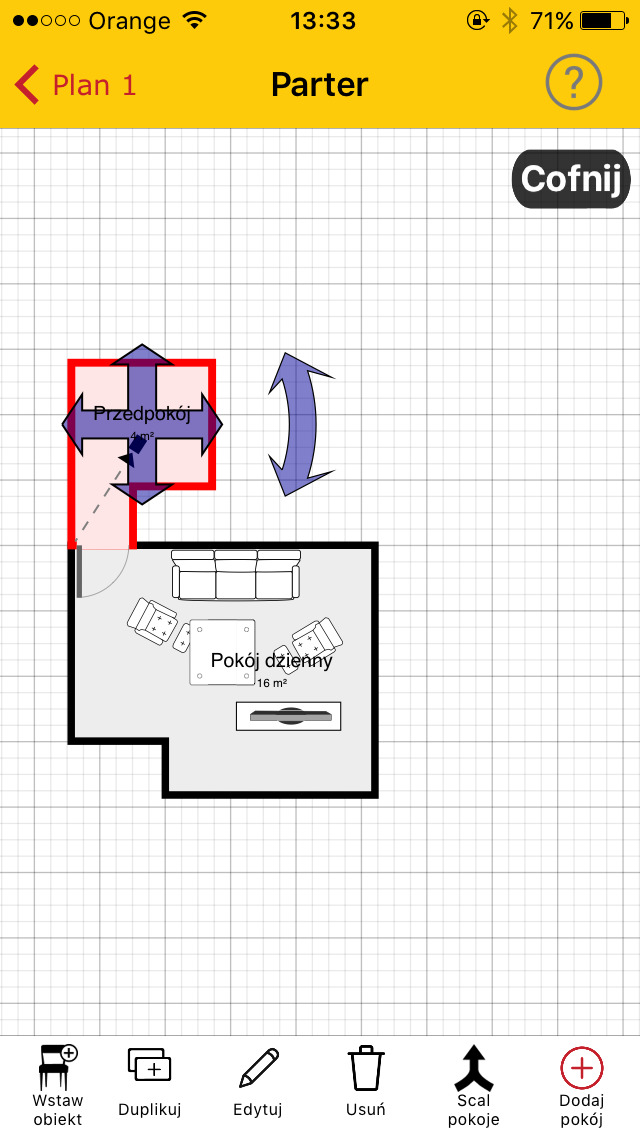

Nie mamy wątpliwości, że największą ciekawostką sprzętową 2017 roku będzie skaner laserowy 3D Leica BLK360. To pierwsza na świecie tego typu konstrukcja, która przy rozmiarach litrowego słoika i masie niecałego kilograma jest pełnowartościowym skanerem przestrzennym. Instrument mierzy 360 000 punktów na sekundę, wykonuje tradycyjne zdjęcia panoramiczne w zakresie 360° i fotografie w podczerwieni, a realistyczny model pomieszczenia tworzy w niespełna 3 minuty.

O dziwo, producent wciąż nie podaje dokładności i zasięgu instrumentu. Te parametry zdecydują, do jakiego zakresu prac będzie się nadawał skaner Leica BLK360.

Do obsługi skanera Leica aplikację stworzyła firma Autodesk – ReCap 360 Mobile. Narzędzie to – instalowana na tablecie iPad Pro – pozwala nie tylko bezprzewodowo (przez Wi-Fi) sterować pracą skanera, ale głównym jego zadaniem jest obsługa chmur punktów. Oprogramowanie pozwala m.in. automatycznie łączyć skany wielostanowiskowe, zarządzać danymi i edytować je, generować realistyczne wizualizacje czy wirtualne spacery.

Można śmiało stwierdzić, że mini skaner Leiki i przygotowane do jego obsługi oprogramowanie Autodesku to odpowiedź na rynkowe potrzeby BIM-u – modelowania informacji o budynkach. W uproszczeniu zakłada ona tworzenia dokumentacji o obiektach w postaci modeli 3D i wykorzystywania ich do prac projektowych.

Na zakup skanera laserowego 3D Leica BLK360 trzeba przeznaczyć ok. 15 000 euro, a jego dystrybucja będzie prowadzona we ścisłej współpracy z firmą Autodesk. I choć instrument wejdzie do sprzedaży dopiero w marcu tego roku, to z kuluarów wiemy, że pod koniec 2016 r. na całym w świecie w kolejce po odbiór nowej zabawki czekało już blisko 100 przyszłych użytkowników.

2. Modelowanie 3D dla mas

Niejako uzupełnieniem możliwości wspomnianego powyżej lasera 3D Leica w marcu 2017 roku Microsoft ma udostępnić mobilną aplikację Capture 3D, która pozwoli w wyjątkowo prosty i szybki sposób generować modele 3D otaczających nas obiektów. Do ich stworzenia wystarczy smartfon z kamerą! Przy okazji Microsoft zaprezentuje zupełnie odmienioną wersję poczciwego Painta, która pozwoli na podstawową edycję takich modeli z komórki.

Na ile rozwiązania te będą proste w obsłudze, szybkie i dokładne, na razie trudno powiedzieć. Ale nawet jeśli nie okażą się rewolucyjne, to naszym zdaniem będą kamyczkiem, który tę rewolucję wywoła. Już teraz wiemy bowiem, że inni dostawcy oprogramowania pracują nad podobnymi aplikacjami. Przykładem jest Bentley Systems (znany np. z aplikacji MicroStation), który szykuje działające w chmurze oprogramowanie ContextCapture. Według zapewnień producenta aplikacja powinna w ekspresowym tempie generować modele 3D o inżynierskiej jakości. Niechybnie to sprawdzimy!

Nie możemy się także doczekać kolejnych wdrożeń technologii Google Tango, która pozwala pozyskiwać za pomocą smartfonów i tabletów gęstą chmurę punktów (szerzej o niej we wcześniejszym wpisie). Na razie ich liczba jest bardzo skromna, ale zapowiedzi producentów urządzeń mobilnych pozwalają przypuszczać, że w 2017 roku znacznie wzrośnie.

3. Skok w wirtualną rzeczywistość

Portale poświęcone nowinkom technologicznym coraz więcej miejsca poświęcają wirtualnej rzeczywistości (VR), do której możemy łatwo wskoczyć, zakładając specjalne gogle. Zapewne w tym roku będą one topowym prezentem na pierwszą komunię, wszak ich wybór jest spory, ceny przystępne, a doznania z użytkowania niezapomniane.

Co jednak ta zabawka ma wspólnego z technologiami pomiarowymi? Gogle VR same w sobie do pomiarów się nie nadają, choć teoretycznie mogłyby je wykonywać (mają sensor głębi), tyle że z kiepską dokładnością. Mimo to producenci sprzętu i oprogramowania pomiarowego patrzą na tę technologię z dużym zainteresowaniem. Przede wszystkim dlatego, że jest ona świetnym narzędziem do efektownej wizualizacji danych przestrzennych i interakcji z nimi. Polski oddział firmy Skanska chce np. od tego roku zacząć wykorzystywać wirtualną rzeczywistość do prezentowania klientom swoich inwestycji deweloperskich w formie modeli 3D.

↓ Tak dzięki VR ma w ocenie Trimble’a wyglądać praca inżyniera

Trwają także prace nad aplikacjami VR dla inżynierów. Na przykład architekt mógłby za ich pomocą wyświetlić sobie w szczerym polu swój projekt budynku, by upewnić się, że inwestycja ma „ręce i nogi”, bądź też porównać różne jej warianty. Specjalne aplikacje zasilone szczegółowymi modelami 3D mogłyby ponadto pomóc w inspekcjach złożonej infrastruktury – wskażemy palcem rurę, a przed oczami ukażą się nam jej szczegółowe parametry. VR mogłaby także rozwiązać wiele problemów z podziemnymi obiektami. Na przykład operator koparki mógłby założyć gogle VR i dzięki nim kopać tak, by nie trafić w pobliski gazociąg. Wszystkie tego typu aplikacje łączy jedno – wymagają zasilenia danymi przestrzennymi. Popularyzacja VR oznacza więc dla specjalistów od pomiarów pełne ręce roboty.

4. Od dronów się nie opędzisz

Według badania Instytutu Mikromakro w Polsce lata już 100 tys. bezzałogowych maszyn latających! Oczywiście zdecydowana większość to zabawki, ale profesjonalistów również przybywa. Już 3,6 tys. osób posiada specjalny certyfikat niezbędny do wykorzystania dronów w celach komercyjnych, a tylko między majem a listopadem wydano ich aż tysiąc! Cieszy, że ten szybko rosnący popyt zaspokajają również polscy producenci UAV.

Żeby nie być gołosłownym, wśród ciekawych bezzałogowych zapowiedzi na nowy rok można wymienić np. Dron Academy Software tworzone przez polską spółkę Dron Academy. Oprogramowanie ma generować ortofotomapy niemal w czasie rzeczywistym i wyświetlać je na pulpicie operatora.

↓ Oprogramowanie Drone Academy generuje ortofotomapę jeszcze w trakcie nalotu

Spodziewamy się, że w 2017 prezentowane będą nowe: sensory (coraz mniejsze, dokładniejsze i bardziej specjalistyczne), maszyny (coraz bardziej autonomiczne) i oprogramowanie (coraz szybciej generujące ortofotomapy czy chmury punktów). Nie mniej ważna będzie cena tych rozwiązań, która na pewno będzie spadać.

5. Galileo, czyli europejskie jest lepsze

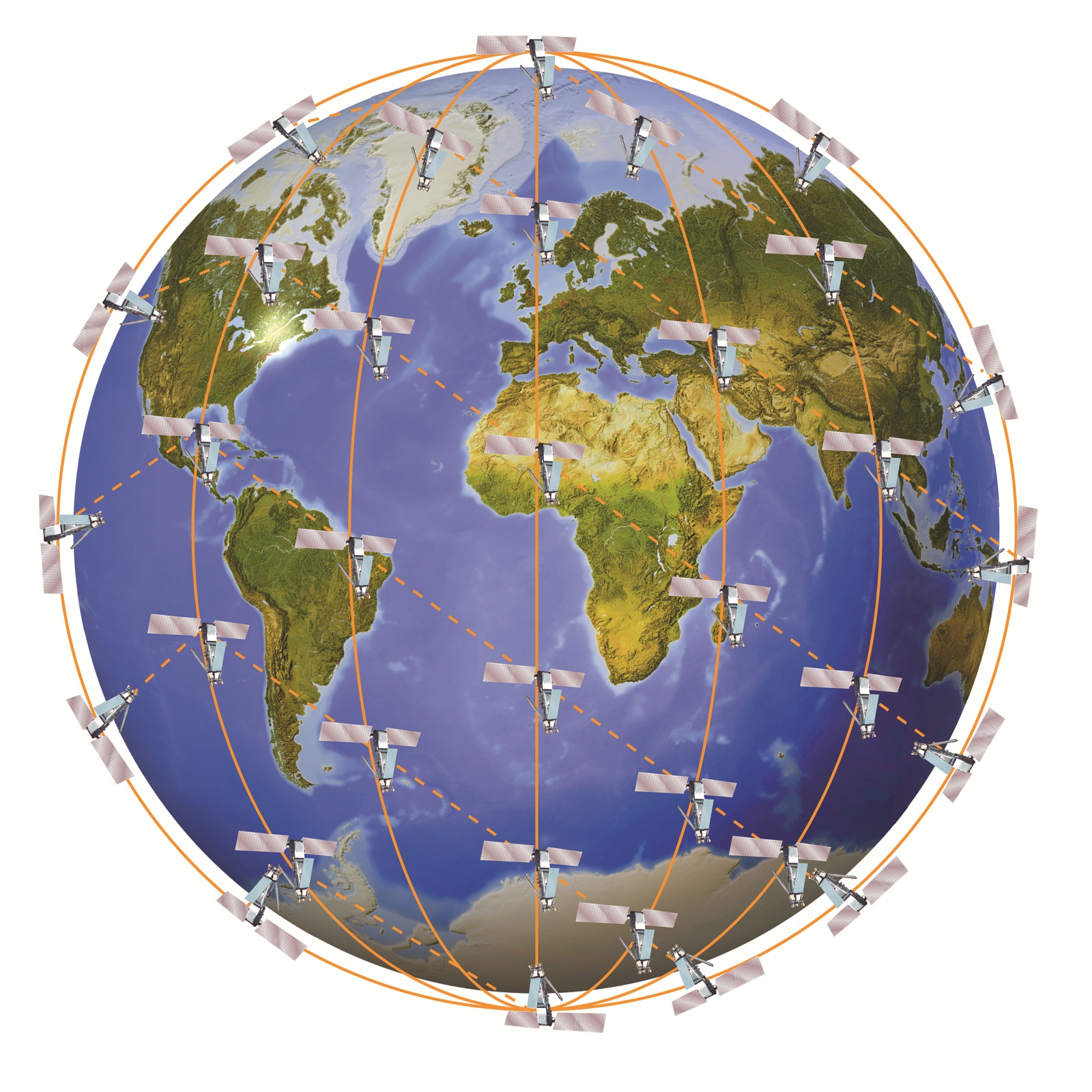

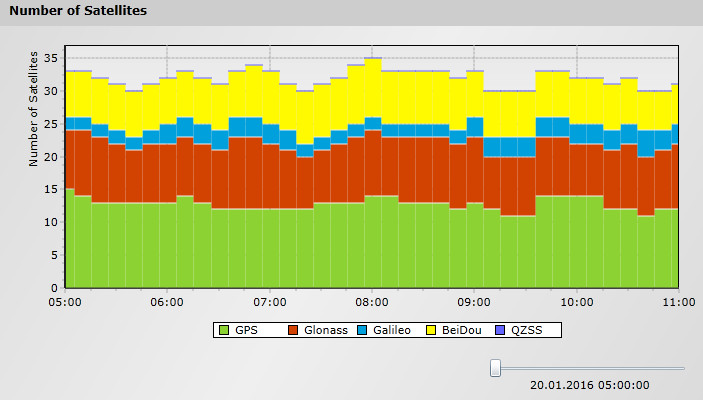

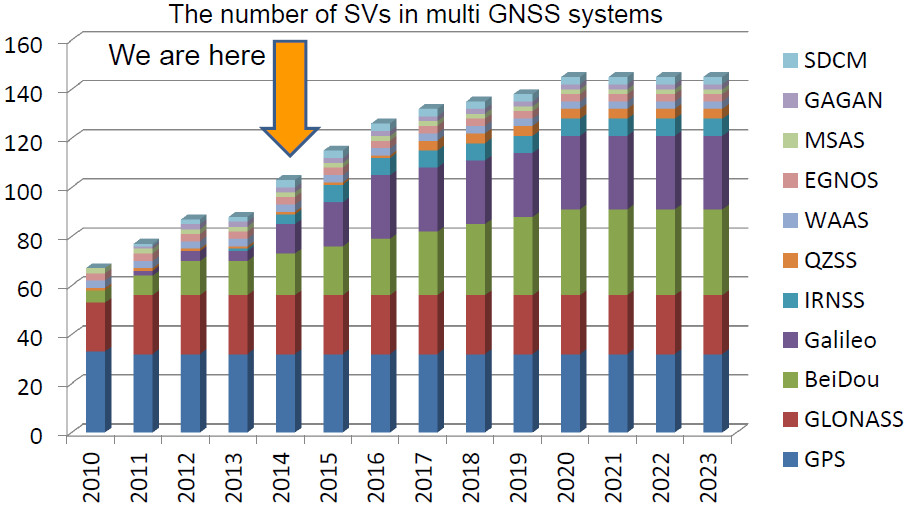

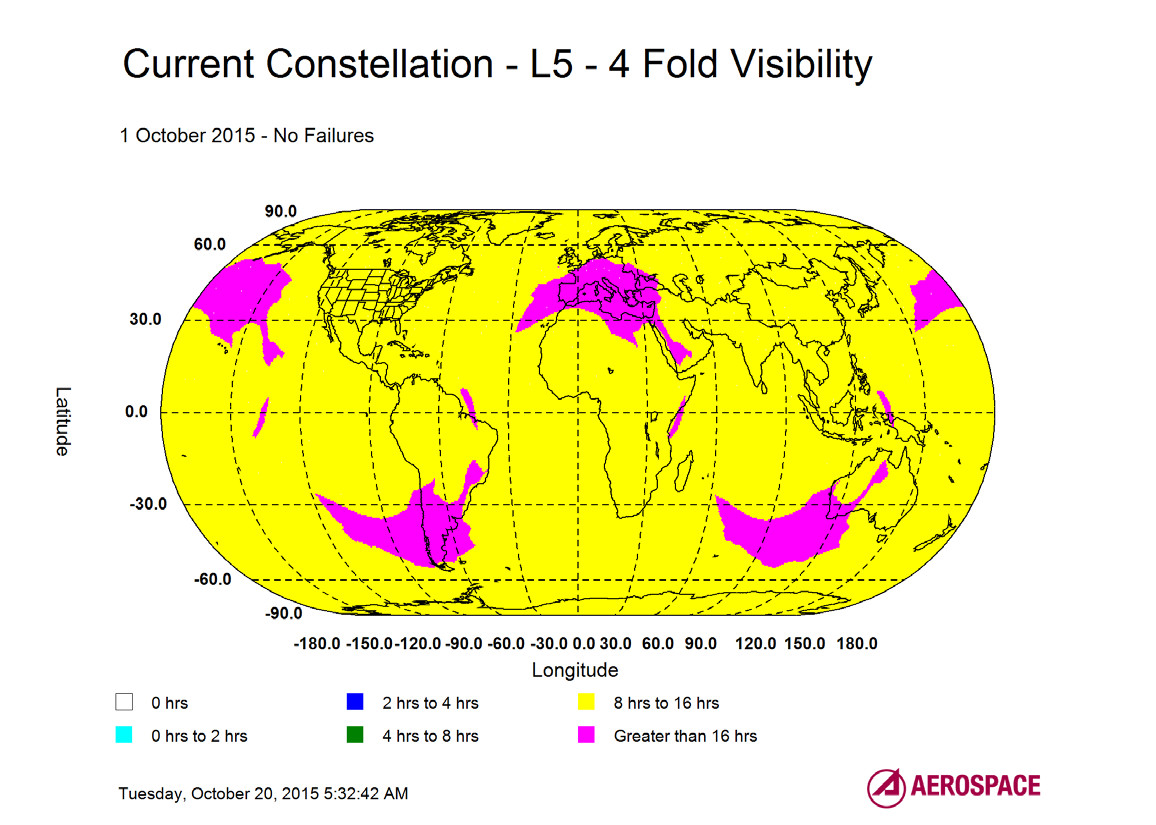

15 grudnia 2016 roku uruchomiono pierwsze usługi europejskiego sytemu nawigacji satelitarnej Galileo. Na razie radość jest umiarkowana, bo wciąż zdecydowana większość odbiorników śledzi tylko amerykański GPS. Ale to właśnie w tym roku powinno zacząć się masowe wprowadzanie na rynek elektroniki kompatybilnej z Galileo. Co to oznacza dla jej użytkowników? Korzyści jest wiele.

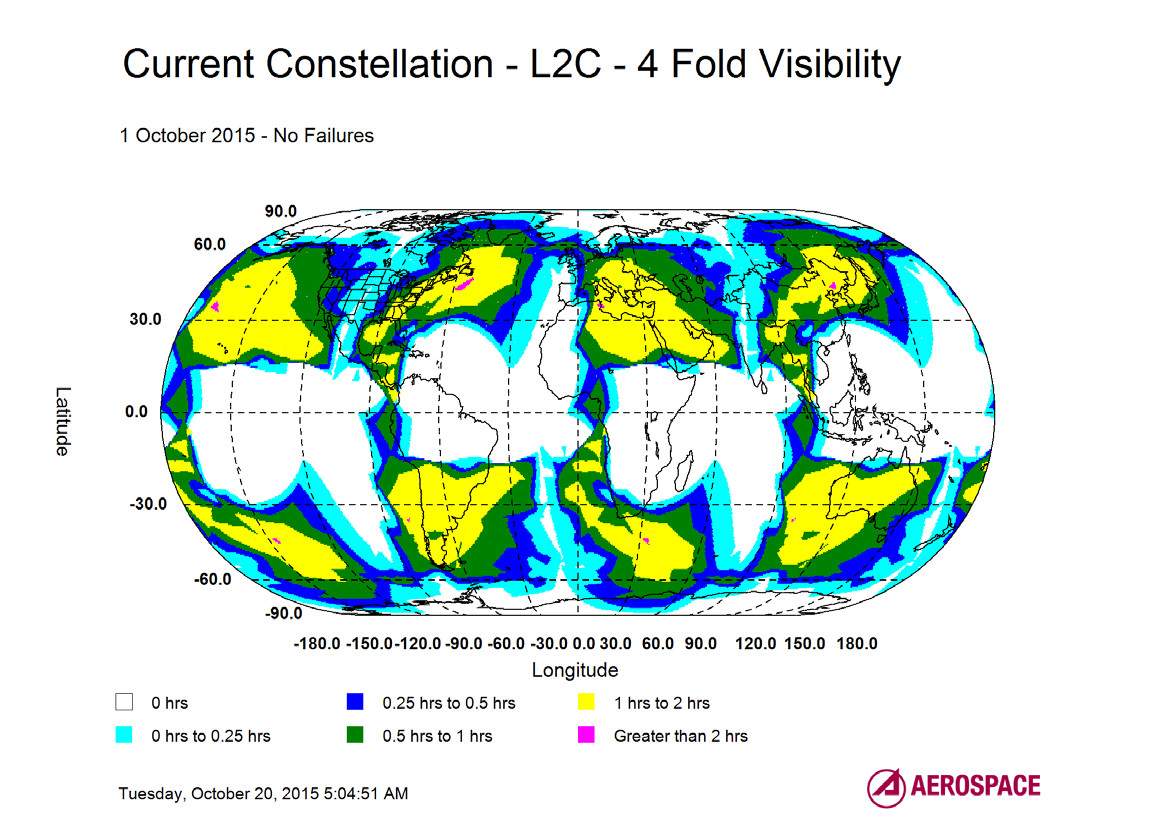

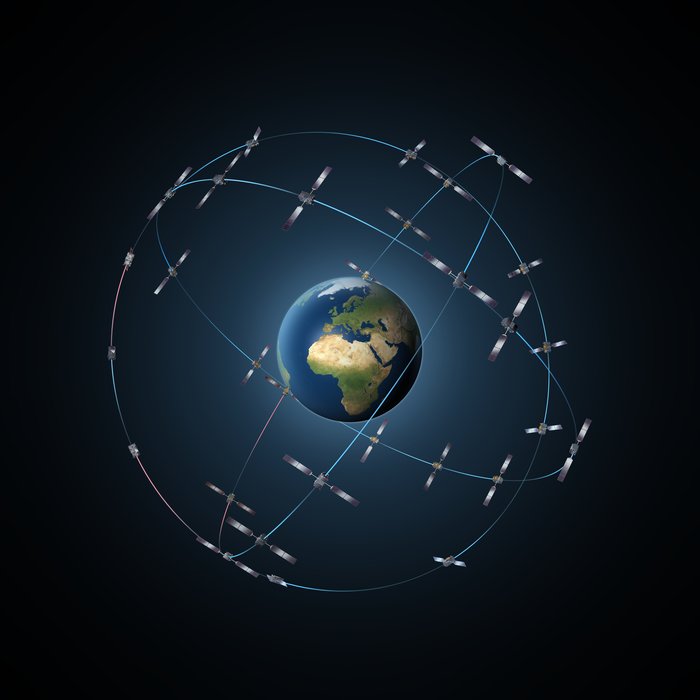

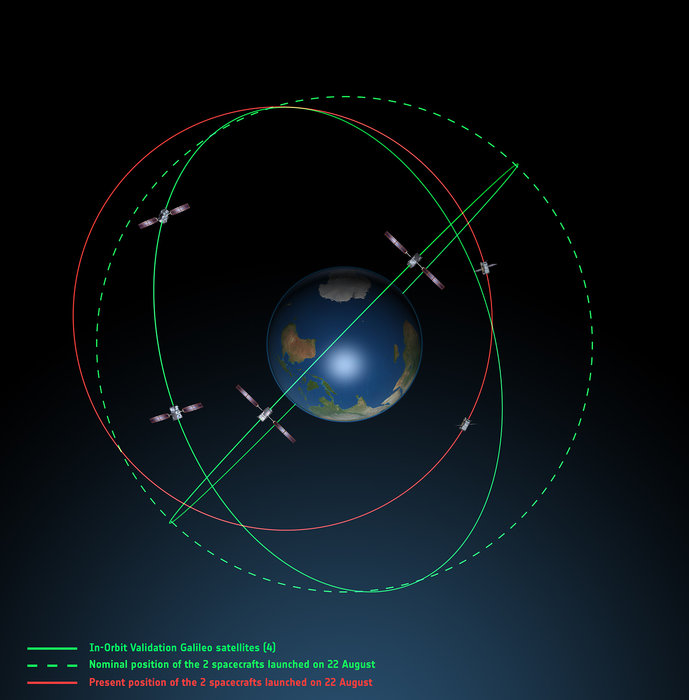

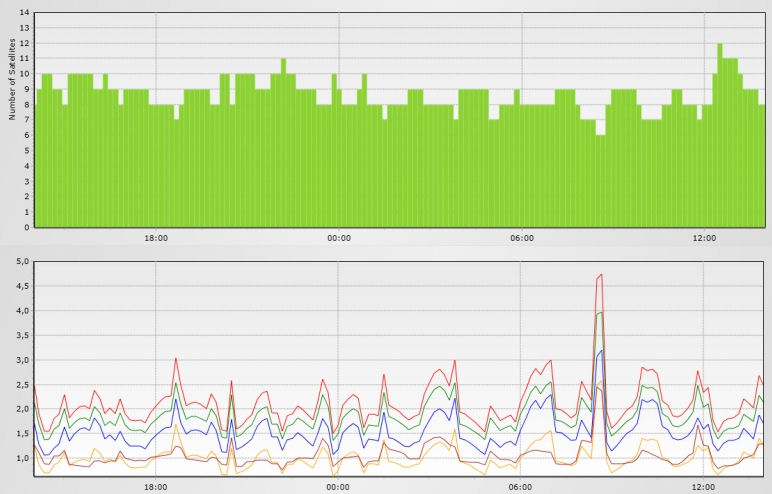

Podstawowa to większa liczba satelitów nawigacyjnych, które może śledzić nasz odbiornik. Na razie w kosmosie jest 18 aparatów Galileo (z czego jeszcze nie wszystkie sprawne), co w Polsce przekłada się na maksymalnie 5 widocznych jednocześnie. Docelowo konstelacja będzie liczyć 30 satelitów. Przy łącznym wykorzystaniu GPS i Galileo oznacza to wreszcie możliwość wykonywania pomiarów w przyzwoitej dokładności w lesie, „miejskich kanionach” czy w górach.

Nawet jeśli będziemy korzystać tylko z Galileo, europejski system będzie nieco dokładniejszy od GPS-a, bo bazuje na nowszych rozwiązaniach technologicznych. Nie powinno to jednak dziwić, wszak amerykański system projektowany był jeszcze w latach 70., a budowa europejskiego rozpoczęła się na początku XXI wieku.

Galileo wyróżnia także bogata oferta różnorodnych usług: darmowej otwartej, bezpieczeństwa życia (oferującej informacje o ewentualnych awariach całego systemu lub poszczególnych satelitów), regulowanej publicznie (dającej upoważnionym służbom sygnały bardziej odporne na zakłócanie), komercyjnej (o znacznie lepszej dokładności, choć płatnej) oraz poszukiwawczo-ratunkowej (umożliwiającej przesłanie ratownikom swojej lokalizacji w dowolnym zakątku świata).

6. Centymetry dla każdego

Po latach teoretycznych rozważań i eksperymentów producenci podzespołów dla odbiorników satelitarnych (np. szwajcarski u-blox) wreszcie ruszają z masową produkcją płyt oferujących technologię RTK L1, które zapewne już w tym roku zaczną być montowane na większą skalę w odbiornikach.

↓ Czip szwajcarskiej firmy u-blox umożliwiający pracę w technologii RTK L1 (fot. u-blox)

Co kryje się pod tym skrótem? RTK to popularna szczególnie wśród geodetów technologia, która pozwala na satelitarny pomiar w czasie rzeczywistym z centymetrową dokładnością. Sęk w tym, że jej stosowanie wymaga posiadania dość drogiego odbiornika (koszt od kilkunastu do kilkudziesięciu tysięcy złotych) śledzącego minimum dwie częstotliwości (L1 i L2).

Tymczasem w przypadku RTK L1 możemy użyć znacznie tańszych (kosztujących nawet około tysiąca złotych) odbiorników jednoczęstotliwościowych. Ich ograniczeniem jest m.in. nieco niższa dokładność (około 10 cm), dłuższy czas inicjalizacji precyzyjnego pomiaru czy konieczność pracy w bliższej odległości od stacji referencyjnej. W wielu zastosowaniach kwestie te nie stanowią jednak większego problemu. Centymetrowa dokładność wreszcie staje się więc dostępna również dla użytkowników z chudszym portfelem.

7. Solidny LiDAR

Już od pewnego czasu w świecie naukowym sporo mówi się o solid state LiDAR (na razie brak dobrego polskiego tłumaczenia tego terminu). W 2017 roku technologia ta wreszcie powinna trafić na rynek. Co to takiego?

Dziś LiDAR-y, czyli skanery laserowe, to stosunkowo drogie, duże i ciężkie instrumenty. To w dużej mierze konsekwencja tego, że składają się z wielu ruchomych części i układów optycznych. W instrumentach solid state LiDAR ich jednak nie uświadczymy, co ma doprowadzić do miniaturyzacji sprzętu oraz znacznego obniżenia ich ceny.

Jeden z producent skanerów – firma Velodyne, opracował już pierwsze układy scalone dla tego typu urządzeń, które zajmują raptem 4 mm kwadratowe i umożliwią budowanie podzespołów dla LiDAR-ów kosztujących raptem… 50 dolarów!

↓ Skanujący układ scalony zaprojektowany przez firmę Velodyne

Oczywiście, podkreślmy, że mówimy o podzespołach. Cały skaner będzie oczywiście większy i droższy, ale i tak powinien być wielokrotnie tańszy od instrumentów obecnie dostępnych w sprzedaży. Jesteśmy wielce ciekawi osiągów tych LiDAR-ów. Firma Velodyne twierdzi, że nasza ciekawość zostanie zaspokojona w 2017 roku.

8. Umierają „okienka”, niech żyje Android

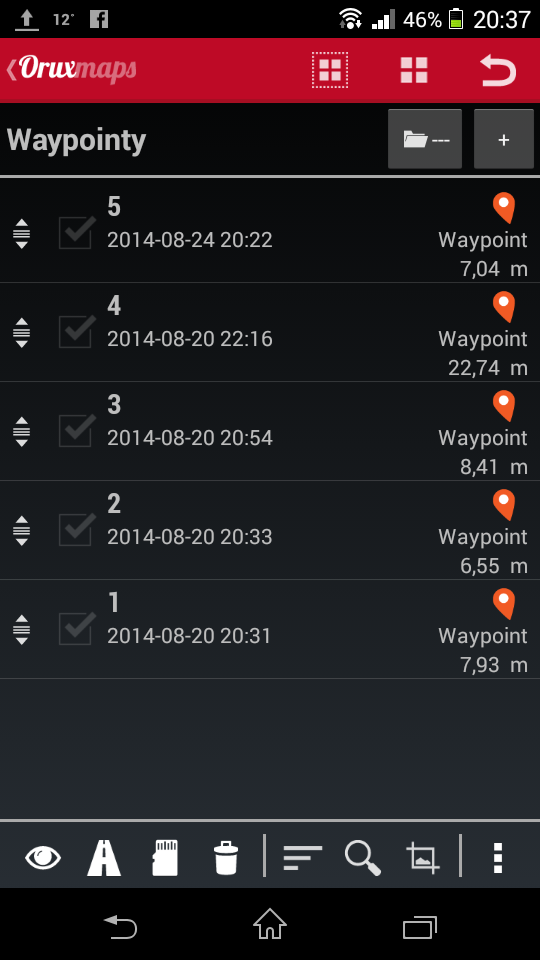

To zadziwiające, jak długo w rejestratorach dla geodezji czy GIS-u funkcjonuje jeszcze archaiczny system Windows Mobile lub Windows Embedded. Ale jego dni są policzone! Skąd ta pewność? Już od kilku lat producenci systematycznie przerzucają się na Androida, bo daje użytkownikowi dużo większą swobodę pracy.

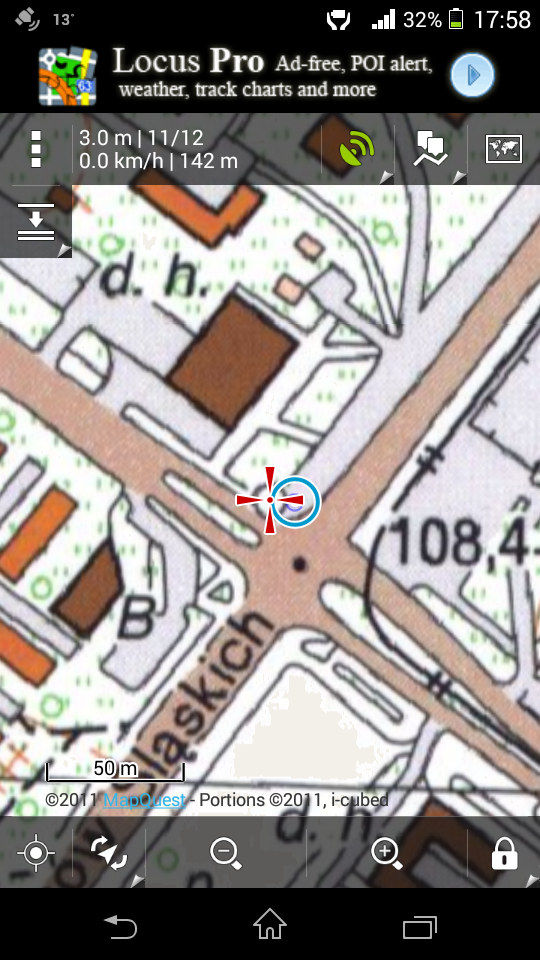

Gwoździem do trumny „okienek” będzie jednak udostępnienie pod koniec 2016 roku Androida w wersji Nougat, którą wyróżnia możliwość uzyskania dostępu nie tylko do wyliczonej przez ten system operacyjny pozycji użytkownika, ale także do surowych obserwacji GNSS.

Co to daje? Ogromne możliwości wspomagania pomiarów, np. poprzez uwzględnienie korekt czy też implementację algorytmów minimalizujących efekt wielodrożności. Nim jednak skorzystamy z tych zalet, deweloperzy muszą opracować specjalnie przystosowane do Nougata mobilne aplikacje pomiarowe. Z pewnością pierwsze z nich wejdą na rynek w 2017 roku i już nie możemy się doczekać, aż będziemy mogli je przetestować!

9. Małe jest piękne

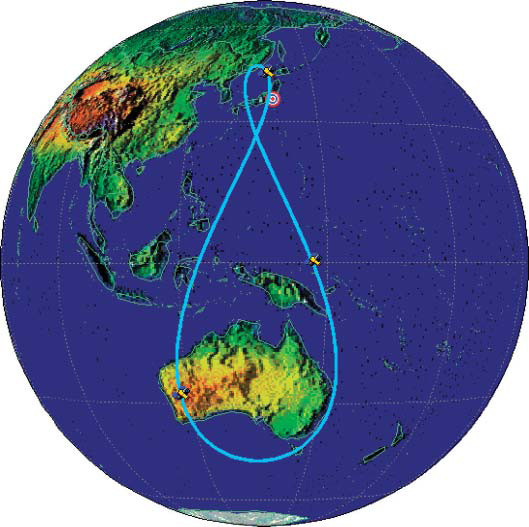

Ręka do góry, kto z Czytelników kupił kiedyś zdjęcie satelitarne? Zapewne nikt i to wcale nie dlatego, że nie potrzebujemy tych danych, ale ponieważ są one za drogie. W 2017 roku powinno się to jednak diametralnie zmienić, a wszystko za sprawą wystrzeliwanych masowo mikro- i minisatelitów obserwacyjnych. Choć koszt ich budowy i wyniesienia jest wielokrotnie niższy niż w przypadku obecnie funkcjonujących dużych satelitów teledetekcyjnych, to te małe aparaciki są w stanie pozyskiwać niewiele gorsze dane. W oczywisty sposób przełoży się to więc na znacznie niższy koszt zobrazowań. Ponadto dzięki temu, że są na ogół pozyskiwane przez liczną konstelację, zdjęcia mogą być bardzo często odświeżane.

Na razie jedną z największych konstelacji minisatelitów jest Dove amerykańskiej firmy Planet (składa się już z ponad 100 aparatów). Oprócz tego powstaje kilka mniejszych systemów obserwacyjnych, np. SkyBox (kupiony przez Google’a) czy BlackSky. O tym, że tego typu biznesy mają sens, niech świadczy to, że własną tego typu konstelację chce mieć również firma DigitalGlobe, która swoją pozycję zbudowała na dostarczaniu danych z dużych i drogich satelitów.

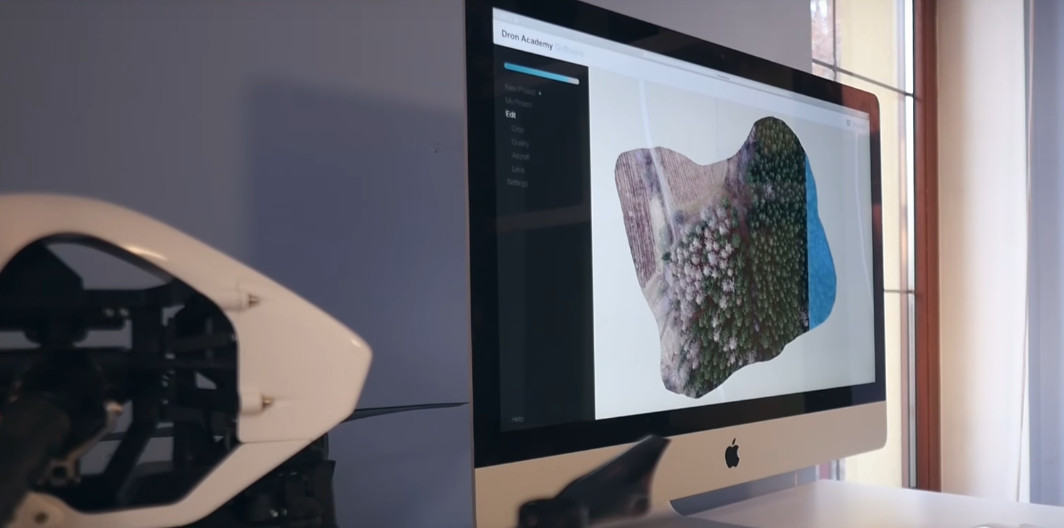

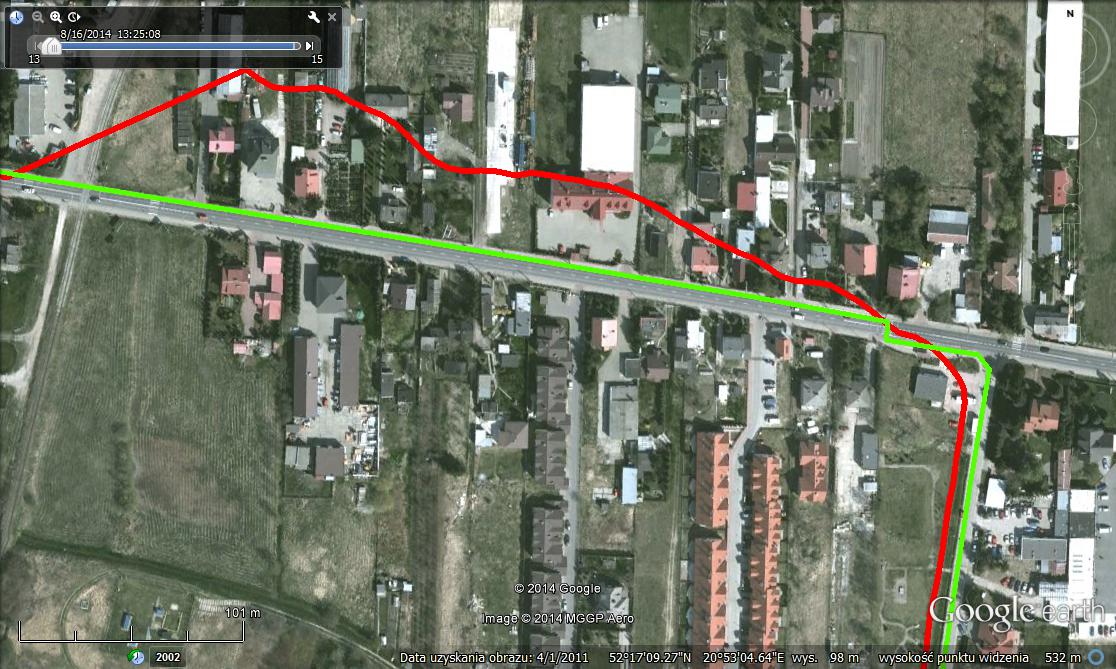

10. Cyfrowy skok za unijną kasę

Zajrzyjmy na nasze, polskie podwórko. Tu także szykuje się sporo zmian, głównie za unijne pieniądze. Z opóźnieniem, ale jednak, w 2017 r. z kopyta ruszy wiele krajowych i regionalnych przedsięwzięć dotyczących cyfryzacji urzędowych danych, również przestrzennych. Stwarzają one realną szansę, że wreszcie pożegnamy się z analogowymi mapami geodezyjnymi i topograficznymi, a w ich miejsce dostaniemy nowoczesne, cyfrowe bazy dostępne łatwo i szybko przez internet. Uważnie warto obserwować choćby projekty Głównego Urzędu Geodezji i Kartografii. W jego planach jest m.in. uruchomienie Geoportalu w wersji 3D oraz rozbudowanie Portalu PZGiK (internetowego sklepu z danymi przestrzennymi) o archiwalne zdjęcia lotnicze kraju.

↓ Tak będzie prezentować się Geoportal 3D

Które z powyższych propozycji najbardziej zmienią w przyszłym roku świat pomiarów? A może macie własne przewidywania? Podzielcie się nimi w komentarzach!